Elastic Fabric Adapter(EFA)是 Amazon EC2 实例的网络接口,使客户能够在 AWS 上大规模运行需要高级别节点间通信的应用程序。它的定制操作系统 (OS) 旁路硬件接口增强了实例间通信的性能,这对于扩展这些应用程序至关重要。借助 EFA,使用消息传递接口 (MPI) 的高性能计算 (HPC) 应用程序和使用 NVIDIA 多节点协同通信库 (NCCL) 的 Machine Learning (ML) 应用程序可以扩展到数千个 CPU 或 GPU。因此,您可以通过 AWS 云的按需弹性和灵活性获得本地 HPC 集群的应用程序性能。

EFA 作为可选的 EC2 联网功能提供,您可以在任何支持的 EC2 实例上免费启用此功能。此外,EFA 可与用于节点间通信的最常用接口、API 和库配合使用,因此只需稍作修改或无需修改,即可将 HPC 应用程序迁移到 AWS。

优势

更快看到成效

EFA 独特的操作系统旁路联网机制为实例间通信提供了低延迟、低抖动通道。借助此机制,紧密耦合的 HPC 或分布式机器学习应用程序可以扩展到数千个内核,从而使应用程序更快速运行。

灵活的配置

您可以对越来越多的 EC2 实例启用 EFA 支持,并可以灵活地为您的工作负载选择正确的计算配置。只需根据需求变化更改集群配置,然后在新计算实例上启用 EFA 支持即可。无需事先预留容量或提前计划。

无缝迁移

EFA 使用 libfabric 接口和 libfabric API 进行通信。几乎所有 HPC 编程模型都支持此接口,因此您基本上无需修改即可将现有 HPC 应用程序迁移到云端。

EFA 性能

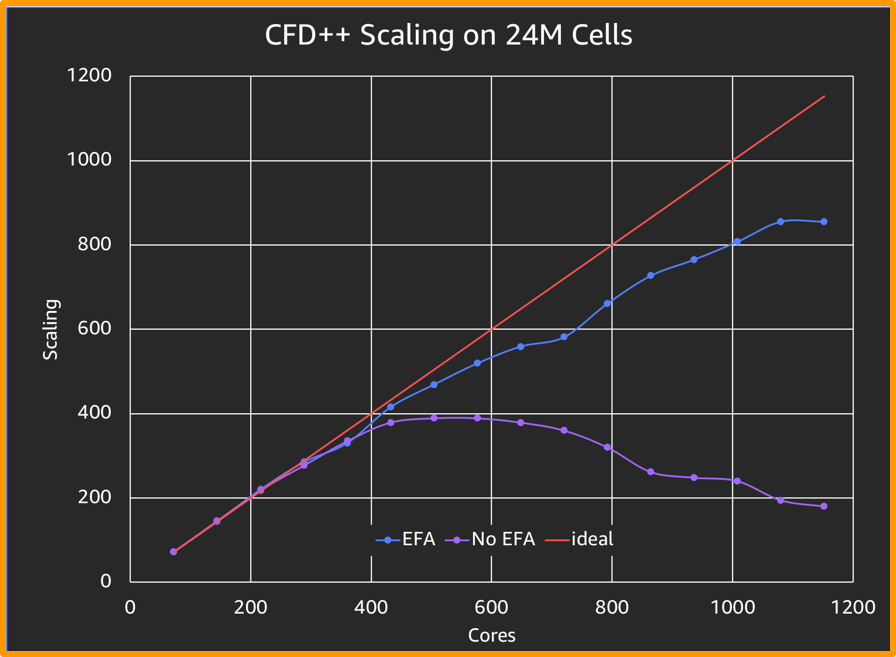

如上图所示,在标准 CFD 模拟中,EFA 提供的扩展比 ENA 提高 4 倍。

Metacomp Technologies 提供该基准的求解器

工作原理

使用案例

计算流体动力学

计算流体动力学(CFD)算法的进步使工程师能够模拟日益复杂的流动现象,而 HPC 有助于缩短解题时间。借助 EFA,设计工程师现在可以扩展他们的模拟工作,以试验更多可调参数,从而获得更快、更准确的结果。

天气建模

复杂的天气模型需要高内存带宽、快速互连和强大的并行文件系统,才能提供准确的结果。模型上的网格间距越近,结果就越准确,而且模型所需的计算资源也越多。EFA 提供快速互连,可让天气建模应用程序利用 AWS Cloud 几乎无限的扩展能力,在更短的时间内获得更准确的预测。

机器学习

通过 GPU 上的分布式计算,可以显著加快深度学习模型的训练。Caffe、Caffe2、Chainer、mxNet、TensorFlow 和 PyTorch 等领先的深度学习框架已经集成 NCCL,以利用其多 GPU 集合进行跨节点通信。EFA 针对 AWS 上的 NCCL 进行优化,提高这些训练模型的吞吐量和可扩展性,从而更快地获得结果。

资源